Seulement 40 % des pages de votre site web sont crawlées par le robot d’indexation de Google. Comment optimiser votre crawl budget et améliorer le référencement naturel de votre site ? On vous dit tout dans cet article ! (qui provient d’une conférence donnée lors du SEO Camp 2017 à Paris)

Crawl budget : qu’est-ce-que c’est?

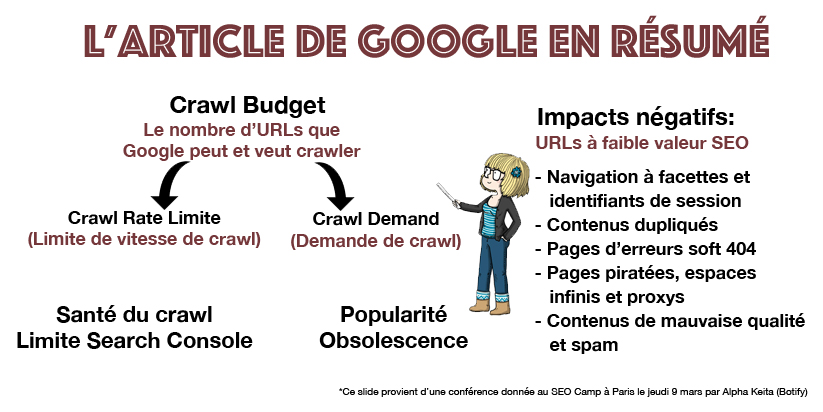

Le crawl budget (ou budget d’exploration) est le temps alloué par Google à l’exploration d’un site internet. Le crawl budget correspond au nombre d’URL que Googlebot, le robot d’indexation de Google, peut et veut explorer. Au plus un site web a de pages, au plus le crawl budget sera important.

Lorsqu’il crawle un site, Googlebot souhaite optimiser son temps de travail en crawlant ce qui est utile et pertinent.

Pour charmer Google et améliorer votre référencement naturel (SEO), favorisez donc un crawl rapide.

Vous avez envie d’en apprendre davantage sur la manière de plaire à Google ? N’hésitez pas à lire ou à relire cet article : « Appliquez ces 4 astuces et Google tombera instantanément amoureux de votre site ».

Optimisation du crawl budget : les gros sites sont concernés

Alors, à qui s’adresse cette notion d’optimisation de crawl budget ? Les sites très volumineux ou les sites plus modestes, ne contenant que quelques milliers de pages ?

Un site de 5000 pages est, en fait, très bien crawlé par Google. Pas besoin de se pencher sur la notion de crawl budget. De même, si Google indexe vos nouveaux contenus le jour même de leur publication, vous n’avez pas à vous préoccuper du crawl budget. Pour optimiser le crawl budget de petits sites, travaillez simplement sur l’analyse de page et la correction des erreurs HTTP.

Astuce : pour vérifier la propreté du code HTML de votre site, passez le test à cette adresse : http://validator.w3.org/. Si nécessaire, rectifiez les erreurs.

Le budget crawl ne concerne donc que les gros sites : ceux qui comportent plusieurs milliers de pages. Votre site fait 10 000 pages ou plus ? Penchez-vous sur l’optimisation du crawl budget de votre site web !

L’article de Google sur le crawl gudget (16 janvier 2017)

Le 16 janvier 2017, Google a publié sur son blog officiel pour les webmasters un article sur le crawl budget et a donné sa propre définition du crawl budget.

Dans cette communication, Google a indiqué que les URL à faible valeur SEO vont avoir un impact négatif sur le crawl budget. L’article de Google peut être résumé comme suit :

Google a expliqué que pour optimiser son crawl budget, il convenait d’éviter les éléments suivants :

- La navigation à facettes

- Les identifiants de session

- Le contenu en double sur le site

- Les pages d’erreurs « soft 404 »

- Les pages piratées Les espaces infinis et proxys

- Le contenu de mauvaise qualité et le spam

- La version AMP d’un site La version multilingue avec l’attribut « hreflang »

- Le nombre de fichiers JavaScript et CSS

Comment mesurer son crawl budget?

Avant d’optimiser le crawl budget de votre site, calculez-le.

Comment procéder pour évaluer son crawl budget ?

- Rendez-vous dans la Search Console de Google. La Search Console vous indique combien de pages sont crawlées chaque jour. Mais attention ! Elle reste un outil limité pour mesurer son crawl budget. La Search Console permet de voir combien de pages sont crawlées chaque jour, mais pas de savoir lesquelles.

- Pour davantage de précision, procédez à une analyse de logs en segmentant les URL. L’analyse de logs permet de visualiser exactement quelles sont les pages crawlées par Google chaque jour.

Pour en apprendre davantage sur l’analyse de log, je vous conseille la lecture de cet article : « Qu’est-ce que l’analyse de logs ? »

Procédez à l’analyse de logs tous les 30 jours. Le reporting sur 30 jours est assez pratique.

Attention, Googlebot crawle aussi les pages orphelines. Pensez à mesurer le taux de crawl utile. Analyser le taux de crawl sur les pages compliants ou indexables uniquement permet d’analyser le pourcentage de pages utiles crawlées par Google.

COMMENT optimiser SON CRAWL BUDGET?

Alors concrètement, comment maximiser son crawl budget ?

Le temps de chargement

Commencez par optimiser le temps de chargement de votre site.

Les erreurs de crawl

Ensuite, prêtez une attention particulière aux pages qui ont de mauvais codes HTTP : elles vont avoir des impacts négatifs sur le crawl budget.

Que faire ?

Réduire au maximum les erreurs HTTP.

PageRank et crawl budget

Sur un site web, Googlebot inspecte les pages par ordre de PageRank. Les pages qui possèdent le plus fort PageRank sont crawlées en priorité. En fonction des ressources qu’il a encore, Googlebot crawle ensuite le reste du site. Les pages qui disposent d’un PageRank beaucoup moins important sont donc beaucoup moins explorées. Pour maximiser le crawl budget, réduisez considérablement la distribution du PageRank sur votre site.

Les pages à faible valeur SEO

Les pages à faible valeur SEO sont à éliminer. En supprimant ces contenus médiocres, les pages importantes recevront davantage de jus. Les pages non indexables et les facettes sans potentiel SEO contribuent à la dilution de PageRank.

Que faire ?

- Analyser le pourcentage du PageRank interne

- Réduire au maximum le nombre de pages à faible valeur SEO dans la structure du site.

Un site contient également des pages vides ou quasiment vides. Identifiez ces pages et sortez-les de la structure de votre site. Elles ont très peu de chance de générer du trafic organique et contribuent à la dilution du PageRank.

Que faire ?

- Identifier les pages avec très peu de contenu

- Ajoutez du contenu sur ces pages ou supprimez-les de la structure du site. Si ce sont des pages stratégiques, augmentez le texte. Par exemple, une page produit qui n’a pas de descriptif doit être mise à jour.

- Bloquer les pages vides dans le robots.txt.

N’oubliez pas de retirer les liens hypertextes dans ces pages ainsi que tous les liens qui pointent vers les pages bloquées.

Les pages profondes

La profondeur d’une page est le nombre minimum de clics pour atteindre une page depuis la page d’accueil. Conséquence : plus une page est profonde, moins elle tendra à recevoir du PageRank. Le taux de crawl baisse avec l’augmentation de la profondeur. Plus les pages sont profondes dans la structure, moins il est facile pour Google de les crawler. Réduire la profondeur des pages importantes.

Les pages orphelines

Les pages orphelines ne sont pas linkées dans la structure du site, mais sont crawlées par Google.

Que faire ?

Si les pages orphelines ont du potentiel SEO, linkez-les dans la structure. Si elles n’ont pas de potentiel SEO, bloquez-les au crawl des moteurs de recherches (robots.txt). Identifiez, parmi les pages orphelines, celles qui ont du potentiel SEO. Celles qui n’ont pas de potentiel, bloquez-les en utilisant le fichier robots.txt.

Analyser et nettoyer ses sitemaps

Des sitemaps « sales » contribuent à générer des pages orphelines. Que faire ? Identifier les pages des sitemaps non linkées dans la structure du site. Nettoyer les sitemaps si ces pages ne sont pas censées s’y trouver.

L’obsolescence des pages

Estimez le temps de retenue dans l’index des pages. Google va garder les pages d’un site plus ou moins longtemps dans son index. Analyser l’obsolescence des pages permet de savoir à quelle fréquence optimale les pages d’un site devraient être crawlées par Google.

En conclusion

Pour optimiser votre crawl budget dans les règles de l’art, procédez par étape. Attaquez-vous d’abord à la mesure de votre crawl budget. Ensuite, optimisez le crawl budget.

Si vous souhaitez aller encore plus loin, prenez en compte l’obsolescence des pages. Cette analyse va nous permettre d’obtenir une mesure de taux de crawl encore plus pertinente.

Astuce : Par quoi commencer si l’on n’a pas beaucoup de temps ?

- Travailler sur les erreurs de codes HTTP

- Faire attention au linking interne. Les pages importantes doivent recevoir assez de liens internes.

- Le linking horizontal est également négligé.

Voilà, il ne reste plus qu’à vous y mettre !

* Étude basée sur les clients de Botify

Cet article est tiré d’une conférence donnée au SEO Camp 2017 par Alpha Keita @_alphaKeita_